Contrast:High contrast|Normal view

AI ACT

Il nuovo Regolamento è indirizzato a tutti coloro che offrono prodotti e servizi basati sull’intelligenza artificiale. I sistemi di IA comprendono applicazioni che forniscono contenuti, formulano previsioni o raccomandazioni, oppure incidono sui processi decisionali degli utenti.

Il Regolamento prevede un approccio basato sul rischio in modo da garantire uno sviluppo e utilizzo responsabile dei sistemi di intelligenza artificiale. Sono vietate le pratiche contrarie ai principi e ai valori dell’Unione europea e quelle che rappresentano un rischio inaccettabile per i diritti fondamentali degli utenti.

Il Regolamento è il primo atto legislativo a livello mondiale a regolamentare la materia facendo fronte a rischi come distorsioni, discriminazioni e mancanza di responsabilità. Allo stesso tempo promuove l’innovazione e la diffusione dell’IA.

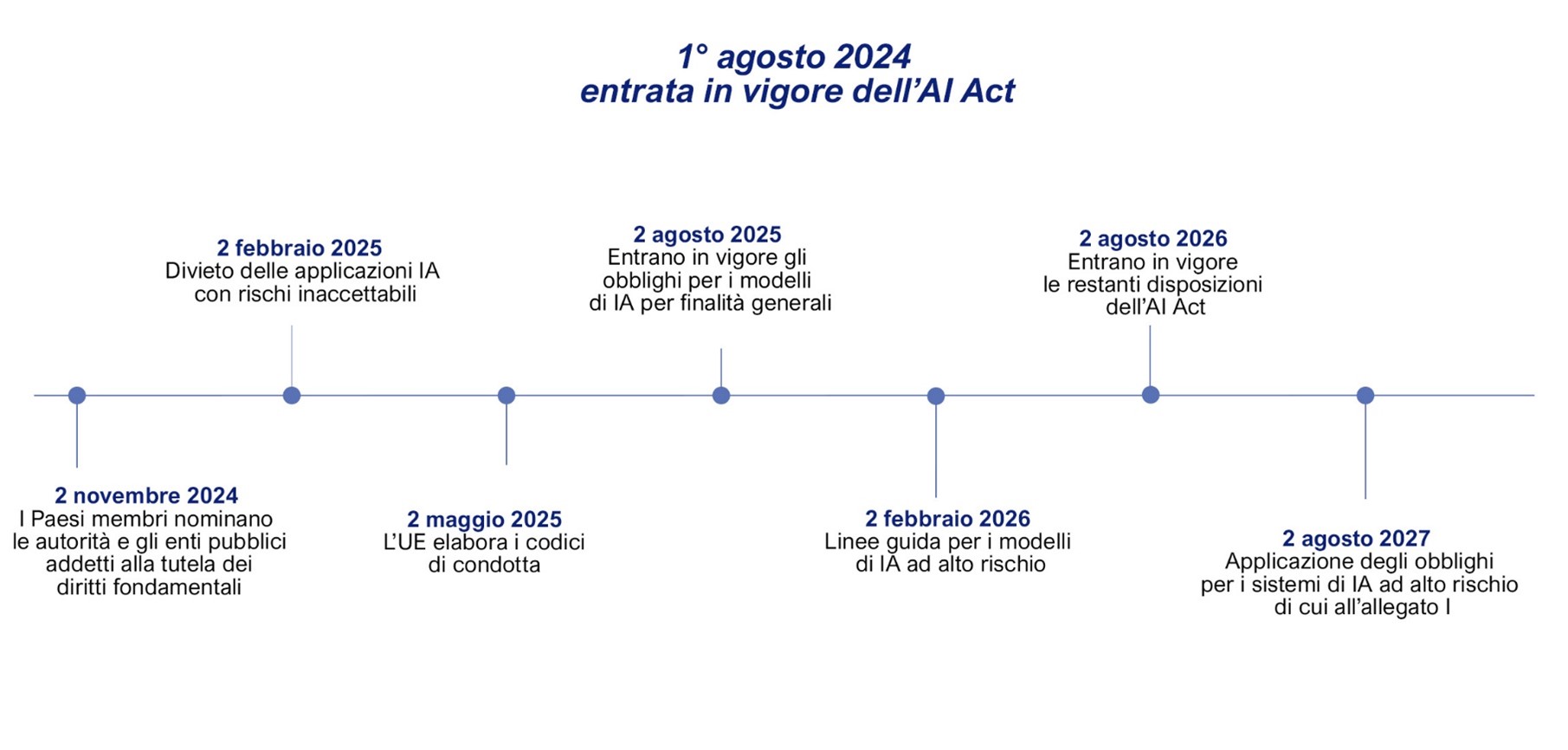

Tempistiche di attuazione

Per ulteriori informazioni relative al calendario si veda:

Ambito di applicazione

Il Regolamento si applica ad attori pubblici e privati all’interno e all’esterno dell’UE, a condizione che il sistema di IA sia immesso sul mercato UE o abbia un impatto sulle persone situate nell’Unione europea. Sono escluse le attività di ricerca e sviluppo e quelle svolte per scopi militari.

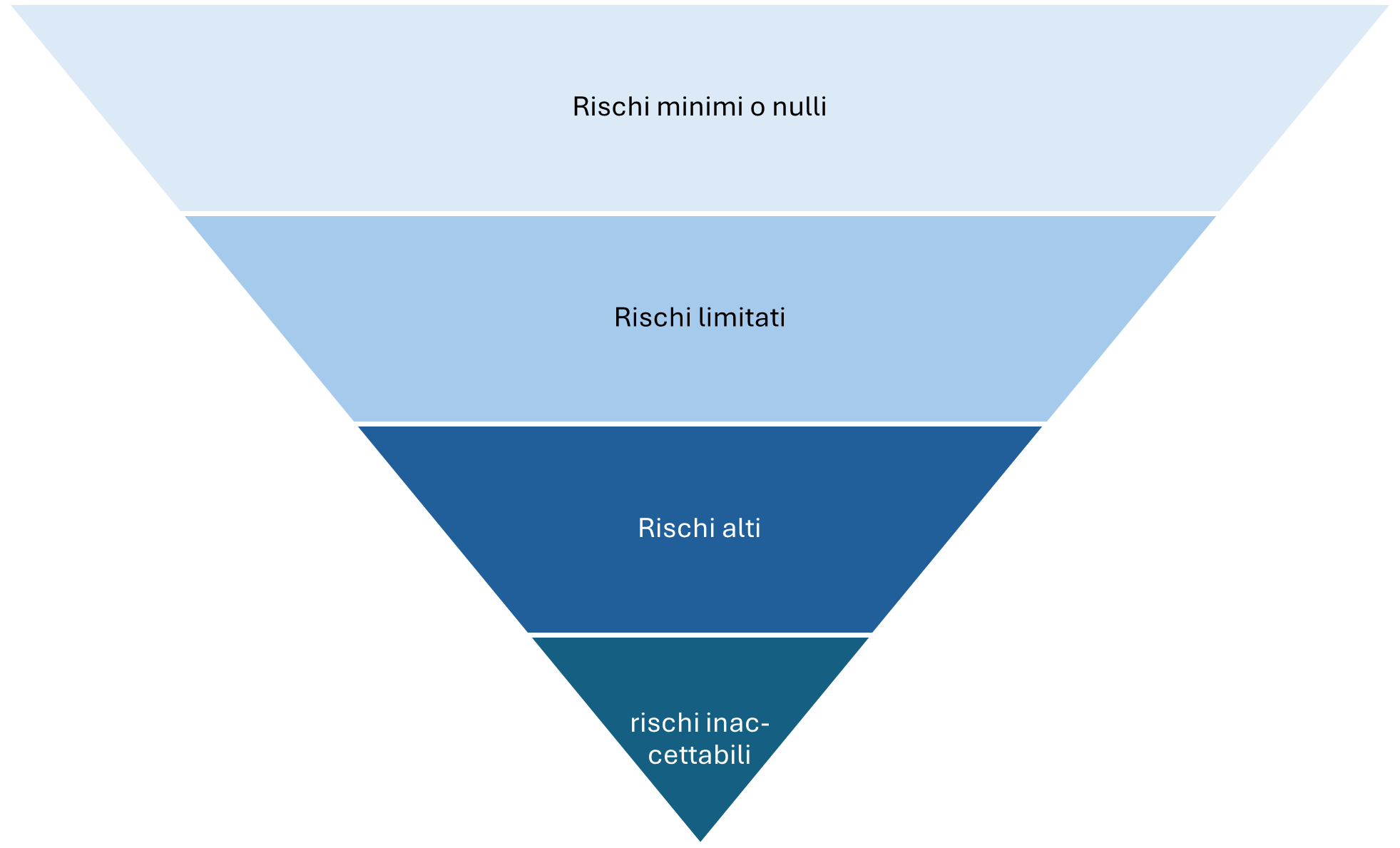

Quattro livelli di rischio

Secondo il principio "rischi più elevati, regole più severe", le applicazioni IA sono suddivise in quattro livelli di rischio.

- Rischi minimi o nulli: la maggior parte dei sistemi di IA, ad esempio i filtri antispam e i videogiochi basati sull’IA, non è soggetta a particolari obblighi; le imprese hanno comunque la facoltà di prevedere ulteriori codici di condotta.

- Rischi limitati: per i sistemi rientranti in questa categoria sono previsti precisi obblighi di trasparenza. Nel caso delle chatbot, ad esempio, l’utente va informato del fatto che sta interagendo con una macchina. In questa categoria rientrano anche alcuni contenuti generati con l’IA che devono essere segnalati come tali.

- Rischi alti: i sistemi di IA ad alto rischio (ad esempio quelli utilizzati nella diagnosi di malattie, nella guida autonoma o per l’assunzione di personale) sono soggetti a requisiti e obblighi più restrittivi che prescrivono, ad esempio, determinate procedure di controllo, banche dati di alta qualità, informazioni chiare all’utenza o la supervisione umana.

- Rischi inaccettabili: è vietato l’utilizzo di sistemi di IA che rappresentano una minaccia palese per la sicurezza, i diritti o i mezzi di sussistenza delle persone. Ciò vale ad esempio in caso di manipolazioni cognitivo-comportamentali, per il riconoscimento delle emozioni sul luogo di lavoro e negli istituti di istruzione o per i sistemi di punteggio sociale.

Per ulteriori informazioni si veda: